欢迎进入某某教育官方网站!

咨询热线:400-123-4567

理论篇2:深度学习之----优化器(1)

发布时间:2024-07-29 16:07:35

?

?

活动地址:CSDN21天学习挑战赛

用来更新和计算影响模型训练和模型输出的网络参数,使其逼近或达到最优值,从而最小化(或最大化)损失函数。

梯度下降法GD(Gradient Descent)

批量梯度下降法 BGD(Batch Gradient Descent)

随机梯度下降法SGD(Stochastic Gradient Descent)

小批量梯度下降法 MBGD(Mini-Batch Gradient Descent)

Momentum

AdaGrad

RMSprop

Adam(Adaptive Momentum Estimation)

梯度下降法简单来说就是一种寻找使损失函数最小化的方法。是最原始,也是最基础的优化器。

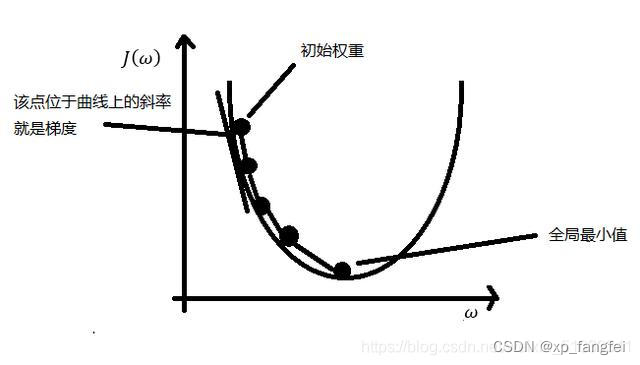

**梯度下降法(Gradient descent )**是一个一阶最优化算法,通常也称为最陡下降法 ,要使用梯度下降法找到一个函数的局部极小值 ,必须向函数上当前点对应梯度(或者是近似梯度)的反方向的规定步长距离点进行迭代搜索。 如果相反地向梯度正方向迭代进行搜索,则会接近函数的局部极大值点;这个过程则被称为梯度上升法 ,相反则称之为梯度下降法。

梯度下降可以理解为你站在山的某处,想要下山,此时最快的下山方式就是你环顾四周,哪里最陡峭,朝哪里下山,一直执行这个策略,在第N个循环后,你就到达了山的最低处

?

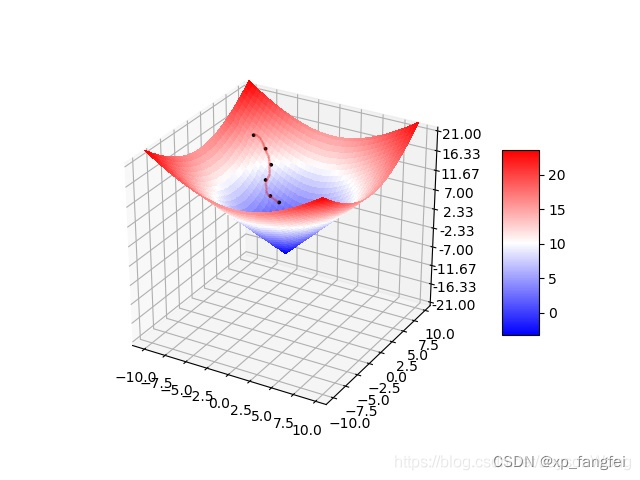

对于三维图的理解:

经过N次迭代损失函数到达最低点。

假设目标函数为J(w),变量为w; 也就是w相当于数据,J(w)为数据对应的标签;

迭代公式如下图:

注意选择学习率:

不能太小,如果选的太小,每次的步长有限,每到达一个点都需要走好多步;

小步长表现为计算量大,耗时长,但比较精准。

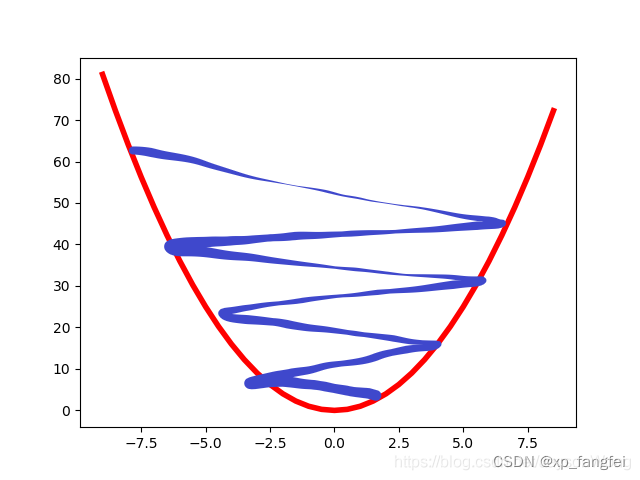

也不能太大,如果太大就可能迈过要下降的地方,使的一直在震荡,并没有真正的下降。

大步长,表现为震荡,容易错过最低点,计算量相对较小。

1、批量梯度下降法 BGD(Batch Gradient Descent)

批量梯度下降法是最原始的形式,它是指在每一次迭代时使用所有样本来进行梯度的更新。从数学上理解如下:

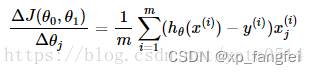

(1)对目标函数求偏导:

其中 i=1,2,…,m 表示样本数, j=0,1 表示特征数,这里我们使用了偏置项 x(i)0=1 。

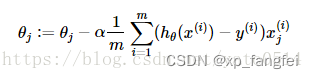

(2)每次迭代对参数进行更新:

注意这里更新时存在一个求和函数,即为对所有样本进行计算处理,可与下文SGD法进行比较。

伪代码形式为:

优点:

缺点:

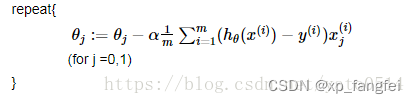

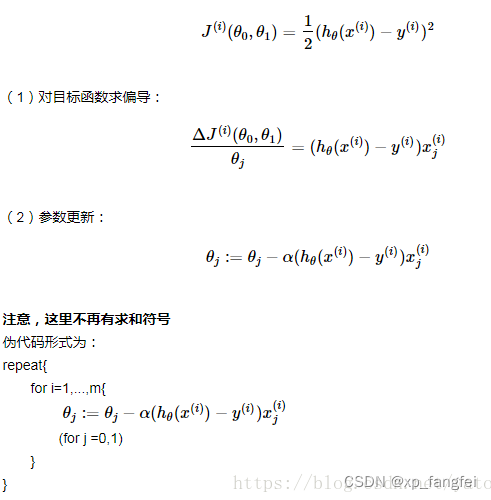

2、随机梯度下降法SGD(Stochastic Gradient Descent)

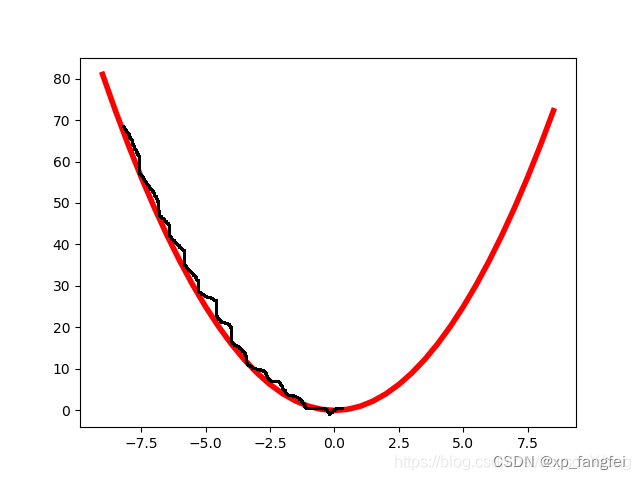

随机梯度下降法不同于批量梯度下降,随机梯度下降是每次迭代使用一个样本来对参数进行更新。使得训练速度加快。

优点:

(1)由于不是在全部训练数据上的损失函数,而是在每轮迭代中,随机优化某一条训练数据上的损失函数,这样每一轮参数的更新速度大大加快。

缺点:

(1)准确度下降。由于即使在目标函数为强凸函数的情况下,SGD仍旧无法做到线性收敛。

(2)可能会收敛到局部最优,由于单个样本并不能代表全体样本的趋势。

(3)不易于并行实现。

3、小批量梯度下降法 MBGD(Mini-Batch Gradient Descent)

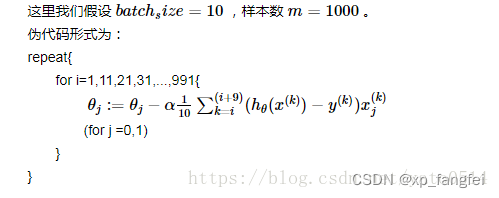

小批量梯度下降,是对批量梯度下降以及随机梯度下降的一个折中办法。其思想是:每次迭代 使用 ** batch_size** 个样本来对参数进行更新。(比较常用的方法)

优点:

(1)通过矩阵运算,每次在一个batch上优化神经网络参数并不会比单个数据慢太多。

(2)每次使用一个batch可以大大减小收敛所需要的迭代次数,同时可以使收敛到的结果更加接近梯度下降的效果。(比如上例中的30W,设置batch_size=100时,需要迭代3000次,远小于SGD的30W次)

(3)可实现并行化。

缺点:

(1)batch_size的不当选择可能会带来一些问题。

先写到这吧,剩下的几种优化器在接下来的博客中介绍!如有问题欢迎指正。